เมื่อ Megapixel ไม่ใช่ทุกอย่างสำหรับกล้อง

By Arnon Puitrakul - 01 กรกฎาคม 2024

ช่วงหลายปีที่ผ่านมา เราเห็นโฆษณาโทรศัพท์พยายามพูดว่ากล้องชั้นดีว่าเธอ โน้นนั่นนี่ แต่สิ่งที่มักนำมาใช้ในการเคลมกันคือ จำนวน Megapixel (MP) ใครเยอะกว่าชนะ เราจะบอกว่า มันเป็นเรื่องตอแหลทั้งเพ วันนี้เราจะมาเล่าให้อ่านกันว่า ทำไมจำนวน Pixel เยอะ ๆ ไม่ได้เป็นตัวตัดสินคุณภาพของกล้อง แล้วเราจะใช้อะไรในการตัดสินแทนละ

หลักการทำงานของกล้องดิจิทัล

เพื่อให้เข้าใจมากขึ้น เราขอพาทุกคนมารู้จักกับหลักการทำงานของกล้องดิจิทัลที่เราใช้งานกันอยู่ในทุกวันนี้กันก่อน โดยทั่ว ๆ ไปกล้องดิจิทัล จะมีส่วนประกอบหลัก ๆ อยู่ทั้งหมด 3 ส่วนด้วยกัน คือ เลนส์, Sensor และหน่วยประมวลผลภาพ ไม่ว่าจะเป็นกล้องบนโทรศัพท์ หรือกล้องระดับ Professional จะมีส่วนประกอบทั้ง 3 ส่วนนี้อยู่เสมอ ๆ

การทำงานของมันคือ แสงจะสะท้อนจากวัตถุ ผ่านเข้าไปในเลนส์ซึ่งทำหน้าที่รวมแสงเข้ามาหากัน และปรับจุดโฟกัสให้ตรงตามที่ต้องการ เลนส์จะมีรายละเอียดอีก เช่น การมีเลนส์สำหรับแก้ไขความผิดปกติของภาพทั้งในแง่ของความเบี้ยว และสี ภายในเลนส์มี รูรับแสง (Aperture) คอยทำหน้าที่เป็นเหมือนก๊อกน้ำ ปรับปริมาณแสงที่เข้าอย่างพอดี หากสภาพแสง ณ ตอนที่ถ่ายมืด มันก็จะเปิดรูรับแสงกว้าง ๆ เพื่อให้รับแสงเข้าได้มากขึ้น กลับกัน หากสภาพแสงด้านนอกสว่างมาก ๆ มันจะหดรูรับแสงให้เล็กลง แสงก็จะเข้าน้อยลงนั่นเอง โดยรูรับแสงมันจะแบ่งออกเป็น 2 แบบคือ แบบปรับได้ และ แบบคงที่ สำหรับแบบปรับได้

จากนั้น แสง จะเข้าสู่ Sensor รับภาพ Sensor จะอ่านค่าออกมาเป็นแสงตามจุดต่าง ๆ ที่ผู้ผลิตกำหนดไว้ ซึ่งหากเทียบกับกล้องสมัยก่อนมันคือ ฟิล์ม หลักการของ Sensor รับภาพคือ เราต้องเก็บแสงสีแยกแต่ละสีออกมา โดยจะแยกออกเป็น 3 สีด้วยกันคือ สีแดง สีเขียว และ สีน้ำเงิน วิธีการแยกง่ายมาก คือการวาง Filter สำหรับรับแสงสีช่วงที่ต้องการเข้ามาแค่นั้นเลย ทำให้ใน 1 จุด Sensor สามารถรับสีได้เพียงสีเดียวเท่านั้น

ซึ่งเรายังสามารถปรับค่าความ Sensitive ของ Sensor ได้ด้วยเช่นกัน ค่านั้นเราเรียกว่า ISO ยิ่งค่า ISO น้อย Sensitive น้อย Sensor จะอ่านเฉพาะค่าแสงที่สูงหน่อย แต่ถ้า ISO สูง ความ Sensitive ก็จะสูง แสงนิดนึงก็อ่านละ แต่นั่นก็มากับสัญญาณรบกวนที่มากขึ้นตามไปด้วย ดังนั้น เวลาเราถ่ายภาพกัน เราจะพยายามไม่ใช้ ISO สูง ๆ ถ่าย เพื่อลดปัญหา Noise นั่นเอง

สุดท้าย เมื่อ Sensor อ่านค่าเข้ามาได้แล้ว จะส่งข้อมูลนั้นไปที่ หน่วยประมวลผลภาพ (Image Processor) โดยมันจะทำหน้าที่หลัก ๆ คือการแปลงสัญญาณที่ได้รับจาก Sensor ให้กลายเป็นภาพที่เราเห็นเป็นไฟล์ภาพได้นั่นเอง โดยมันจะมีกระบวนการหลายขั้นตอนด้วยกัน เช่น การรวมสัญญาณสี แดง,เขียว และ น้ำเงิน เข้าด้วยกัน และการลด Noise ออกจากรูปภาพ เป็นต้น

และนี่คือหลักการทำงานพื้นฐานของกล้องดิจิทัลนั่นเอง โดยกล้องแต่ละแบบอาจจะมีการเพิ่มส่วนประกอบบางอย่างเข้ามา เช่นกล้องแบบ DSLR (Digital Single-Lens Reflex) จะใส่กระจกเข้าไปเพื่อทำหน้าที่สะท้อนภาพขึ้นไปให้เราเห็นบนช่องมองภาพ (Viewfinder) ได้ และปัจจุบันเรามีการพัฒนากล้อง Mirrorless ขึ้นมาคือการเอากระจกที่ว่าออก และอ่านค่าจาก Sensor ไปแสดงผลบน ช่องมองภาพแบบดิจิทัล (Digital Viewfinder) หรือก็คือ ช่องมองภาพที่เป็นจอ และยังมีกล้องแบบอื่น ๆ อีกมากมายที่ถูกพัฒนาขึ้นมาลองไปหาอ่านดูกันได้ บอกเลยว่าเรื่องนี้สนุกมาก

ความละเอียดของ Sensor คิดยังไง ?

มาที่ประเด็นหลักของเราในบทความนี้คือ ความละเอียดของภาพ ซึ่งอย่างที่บอกไปว่า ค่านี้จะอยู่ที่การออกแบบของ Sensor ว่าผู้ผลิตจะมีการใส่ขนาดความละเอียดเท่าไหร่

หากมองในอุดมคติ เราสามารถใส่ ขนาดความละเอียดของ Sensor เท่าไหร่ก็ได้ ตามที่ต้องการ เช่น อยู่ ๆ จะทำให้กล้องนี้สามารถถ่ายในความละเอียด 20,000 MP ก็ย่อมทำได้ เพราะสุดท้ายแล้ว มันคือการที่ผู้ผลิตใส่จุดที่อ่านค่าเข้าไปมากขึ้นเรื่อย ๆ โดยทั่ว ๆ ไป เราจะใส่กันเป็นตาราง ทำให้เราสามารถอนุมานภาพง่าย ๆ ว่า หาก Sensor เรามีความละเอียด 12 MP เปรียบเสมือนว่า มีตารางจำนวน 12 ล้านช่องตีอยู่บน Sensor ของเรา ดังนั้น เราสามารถจะตีมันกี่ช่องก็ได้ 20,000 ล้านช่องก็ทำได้ แต่เอ๊ะ ทำไมมันไม่มีผู้ผลิตกล้องคนไหนทำแบบนั้นละ

นั่นเป็นเพราะ เรายังตกอีกมิตินั่นคือ ขนาดของ Sensor สมมุติว่า Sensor ของเรามีขนาด 1x1 inch และเราตีไป 10 ล้านช่อง เทียบกับ Sensor ตัวเดิม แต่เราตีขึ้นไป 20 ล้านช่อง เหมือนเราตีตารางถี่ขึ้น นั่นทำให้ พื้นที่ต่อช่องของของ 20 ล้านช่องนั้นจะเล็กกว่า 10 ล้านช่องเท่าตัวเลยทีเดียว

ถามว่า แล้วขนาดพื้นที่ต่อช่องที่ว่ามันสำคัญอย่างไร ยิ่งขนาดพื้นที่ใหญ่มากเท่าไหร่ มันก็จะยิ่งรับแสงได้มากขึ้นเท่านั้น ทำให้ลดโอกาสที่จะเกิด Noise ในภาพขึ้น เมื่อผ่านขั้นตอนการลด Noise บนหน่วยประมวลผลยิ่งทำให้รายละเอียดของภาพถูกลดทอนลงไปเป็นเงาตามตัวด้วยเช่นกัน เช่นภาพด้านบนถ่ายจาก iPhone 14 Pro ที่ใช้ Night Mode ช่วยแล้ว แต่รายละเอียดของภาพก็ยังแย่อยู่

ดังนั้น มันจึงไม่ใช่เรื่องแปลกที่หากเราเอาภาพจากกล้องที่มี Sensor ขนาดเล็กอย่างกล้องบนโทรศัพท์ มาเทียบกับกล้อง Mirrorless ที่มี Sensor ขนาดใหญ่กว่า ภาพที่ได้จากกล้องโทรศัพท์ถึงแม้จะมีความละเอียดต่ำกว่า แต่เมื่อเราซูมเข้าไปกลับพบว่า ภาพจากกล้องใหญ่นั้นมีรายละเอียดที่มากกว่าได้นั่นเอง

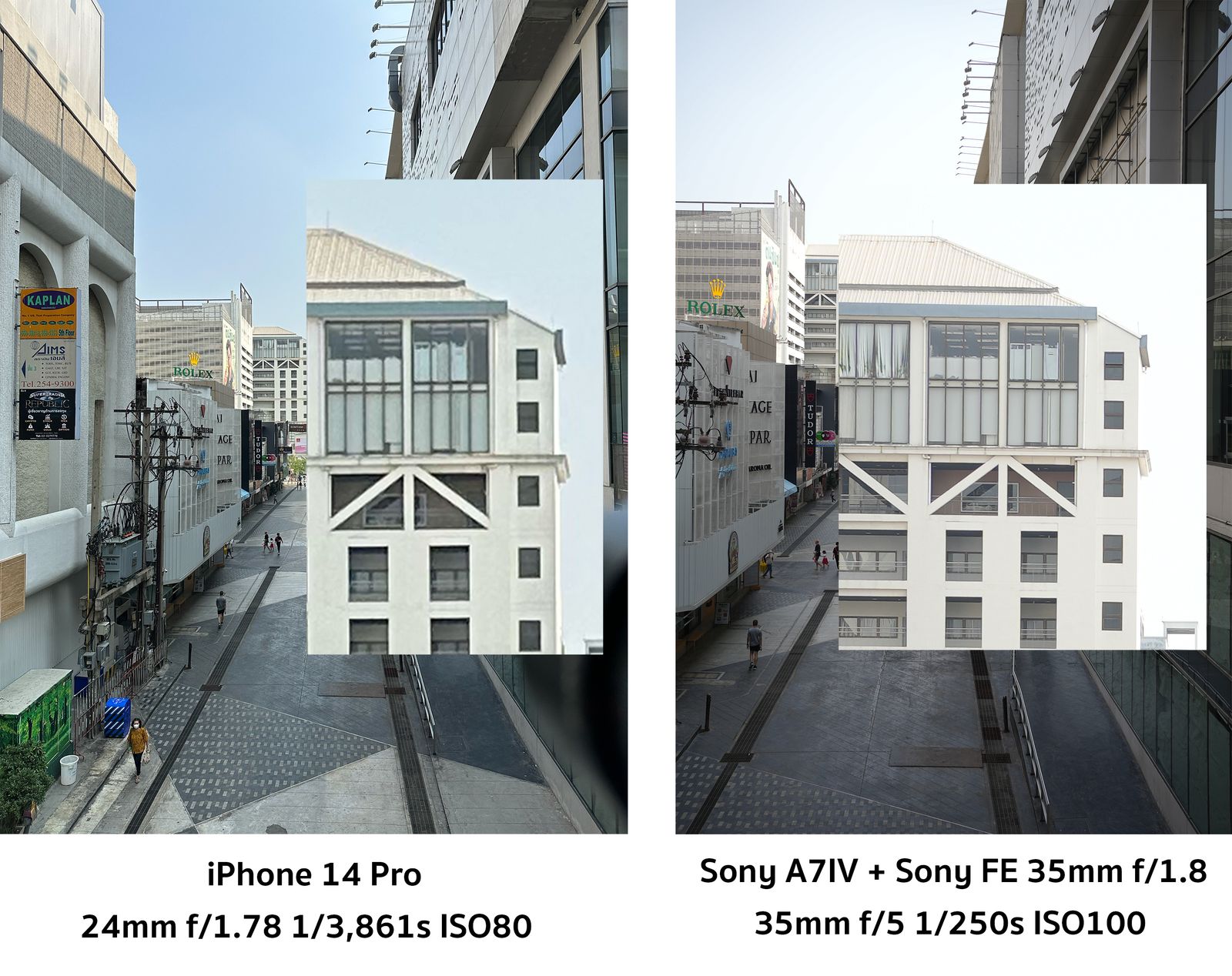

ตัวอย่างเช่นภาพด้านบน ที่เราใช้ iPhone 14 Pro ถ่ายแบบ RAW File ที่ความละเอียด 48MP เทียบกับภาพจากกล้อง Mirrorless อย่าง Sony A7IV ที่มีความละเอียด 33 MP เราจะเห็นว่าภาพที่ได้จากกล้องใหญ่ ถึงจะมีความละเอียดน้อยกว่าพอสมควร แต่เมื่อเราซูมเข้าไปดูรายละเอียดจะพบว่า รายละเอียดของตึกของภาพจากกล้องใหญ่ดูละเอียด คมชัดมากกว่ามาก ๆ

ความละเอียดตามสเปก อาจจะไม่ตรงกับตอนใช้จริงก็ได้

อย่างที่เล่าไปว่า ความละเอียด ยิ่งมากเสมือนเราตีตารางบน Sensor ถี่มากขึ้น พื้นที่ต่อ Pixel จะน้อยลง แต่ผู้ผลิตกล้องบางคน เล่นโกงนิดหน่อย คือ โฆษณาว่า กล้องตัวเองความละเอียดสูงมาก ๆ เช่น 48 MP แต่เวลาถ่ายจริงออกมา ได้ภาพความละเอียดเพียงแค่ 12 MP เท่านั้น หรือก็คือ 1 ใน 4 ของความละเอียดที่เคลมไว้

เคสที่ว่านั่นคือก็ iPhone 14 Pro ที่เราใช้งานนี่แหละ เขาโกงเหรอมันก็ไม่ใช่ แต่เขาทำเพื่อเพิ่มความยืดหยุ่นในการทำงาน โดยการที่ใส่ Sensor ความละเอียด 48 MP มาจริง ๆ แต่ด้วย Sensor ที่เล็กเท่านั้น ถ้าเราอยากเพิ่มคุณภาพของภาพ เราสามารถสั่งให้ หน่วยประมวลผลรวมข้อมูลของ 4 Pixel รวมกัน เราเรียกว่า Subsampling ทำให้ภาพที่ได้จะมีคุณภาพสูงขึ้น Noise จะลดลง เสมือนว่า เราเปลี่ยนจากการตีตาราง 48 ล้านช่องให้เหลือแค่ 12 ล้านช่องบน Sensor ตัวเดิม

ท่านี้ ไม่ได้ทำแค่บนกล้องโทรศัพท์เท่านั้น แต่ยังทำบนกล้องใหญ่ด้วย เช่นกล้องที่เราใช้คือ Sony A7IV ตามสเปกถ่ายวีดีโอความละเอียด 4K ได้ แต่ความละเอียด Sensor มันอยู่ที่ 33 MP ซึ่งทำให้มันถ่ายได้ความละเอียดประมาณ 6K นิด ๆ Sony เลยบอกว่า งั้นก็ถ่ายมาเต็ม 6K ตามที่ Sensor ทำได้นั่นแหละ แต่เอามาทำเทคนิคเดียวกันกับ iPhone นี่ละ ทำให้เราได้วีดีโอที่มีความคมชัดสูงขึ้น Noise ลดลง คุณภาพโดยรวมดูดีขึ้นมาก ๆ

แต่นั่นไม่ได้หมายความว่า กล้องทุกตัวจะ Subsampling ทั้งหมดนะ กล้องส่วนใหญ่ใช้วิธีการอ่านแค่บางส่วนจาก Sensor เท่านั้น คือการกระจายอ่านช่องเว้นช่อง หรืออ่านช่อง เว้น 2-3 ช่องขึ้นกับความละเอียดเดิมของ Sensor ทำให้คุณภาพที่ได้ก็จะไม่ต่างจากการถ่ายภาพปกติเลย

Sensor ความละเอียดสูงมีประโยชน์อย่างไร ?

อ่านมาถึงตรงนี้ อาจจะตั้งคำถามแล้วว่า งั้นเราก็ไม่จำเป็นต้องมี Sensor ความละเอียดสูง ๆ ก็ได้ละสิ คำตอบมันคือทั้งใช่ และไม่ใช่ สำหรับคนทั่ว ๆ ไป ที่ใช้ในชีวิตประจำวัน เน้นถ่ายรูปลง Social Media เราคิดว่าสัก 10-15 MP ก็ถือว่าเพียงพอแล้ว เพราะเวลาเราเอารูปลงจริง ๆ มันจะโดนย่อเหลือราว ๆ 2 MP อยู่แล้ว

แต่สำหรับงานบางประเภท จำเป็นต้องใช้ความละเอียดสูง ๆ เช่นภาพถ่ายทางดาวเทียม ที่เราเน้นการถ่ายภาพเดียว กินพื้นที่สมมุติ 10x10 กิโลเมตร แต่เราต้องสามารถซูมให้ได้เห็นยันตึกที่อยู่ในภาพเล็ก ๆ หรือใช้เป็นเครื่องมือสำหรับช่างภาพที่ ทำให้ช่างภาพกังวลองค์ประกอบของภาพน้อยลง เพราะสามารถนำไป Crop ปรับให้องค์ประกอบของภาพเป็นไปตามที่ช่างภาพต้องการได้ เช่น Sony A7RV ที่ใช้ Sensor ขนาด Full Frame แต่กดไปถึง 61 MP เลยทีเดียว

สรุป : ความละเอียดไม่ใช่ปัจจัยเดียวที่บ่งบอกคุณภาพของกล้อง

ด้วยเหตุทั้งหมดที่เราเล่ามา ทำให้ ความละเอียดจาก Sensor ไม่ใช่ปัจจัยเดียวที่ใช้บ่งบอกคุณภาพของกล้องถ่ายภาพ การที่ MP เยอะกว่า ไม่ได้แปลว่าภาพจะสวยกว่า คมกว่า แต่มันอยู่ที่ขนาดพื้นที่ Sensor ต่อ Pixel มากกว่า ยิ่งมีพื้นที่เยอะยิ่งรับแสงได้เยอะ ภาพที่ได้ก็จะคมชัด สดใส มี Noise น้อยลงนั่นเอง หรือกลับกันที่ผู้ผลิตบางคนเลือกที่จะทำ Gimmick ทางการตลาดในการฝืนใส่ความละเอียดเข้าไปเยอะ ก็คือรู้เลยนะว่าชิบหายการช่างแน่นอน

Read Next...

รวม Homebrew Package ที่รักส์

Homebrew เป็นอีกหนึ่งเครื่องมือที่เราชอบมาก ๆ มันทำให้เราสามารถติดตั้งโปรแกรม และเครื่องมือต่าง ๆ ได้เยอะแยะมากมายเต็มไปหมด แต่วันนี้ เราจะมาแนะนำ 5 Homebrew Package ที่เรารักส์และใช้งานบ่อยมาก ๆ กันว่าจะมีตัวไหนกันบ้าง...

รวมวิธีการ Backup ข้อมูลที่ทำได้ง่าย ๆ ที่บ้าน

การสำรองข้อมูลเป็นเรื่องสำคัญมาก ๆ อารมณ์มันเหมือนกับเราซื้อประกันที่เราก็ไม่คาดหวังว่าเราจะได้ใช้มันหรอก แต่ถ้าวันที่เราจำเป็นจะต้องใช้การมีมันย่อมดีกว่าแน่นอน ปัญหาคือเรามีวิธีไหนกันบ้างละที่สามารถสำรองข้อมูลได้ วันนี้เราหยิบยกวิธีง่าย ๆ ที่สามารถทำได้ที่บ้านมานำเสนอกัน...

Trust ความเชื่อมั่น แต่ทำไมวงการ Cyber Security ถึงมูฟออนไป Zero-Trust กัน

คำว่า Zero-Trust น่าจะเป็นคำที่น่าจะเคยผ่านหูผ่านตามาไม่มากก็น้อย หลายคนบอกว่า มันเป็นทางออกสำหรับการบริหาร และจัดการ IT Resource สำหรับการทำงานในปัจจุบันเลยก็ว่าได้ วันนี้เราจะมาเล่าให้อ่านกันว่า มันคืออะไร และ ทำไมหลาย ๆ คนคิดว่า มันเป็นเส้นทางที่ดีที่เราจะมูฟออนกันไปทางนั้น...

แปลงเครื่องคอมเก่าให้กลายเป็น NAS

หลังจากเราลงรีวิว NAS ไป มีคนถามเข้ามาเยอะมากว่า ถ้าเราไม่อยากซื้อเครื่อง NAS สำเร็จรูป เราจะสามารถใช้เครื่องคอมเก่าที่ไม่ได้ใช้แล้วมาเป็นเครื่อง NAS ได้อย่างไรบ้าง มีอุปกรณ์ หรืออะไรที่เราจะต้องติดตั้งเพิ่มเติม วันนี้เราจะมาเล่าให้อ่านกัน...